發布日期:2022-10-09 點擊率:39

本文重點介紹IBM上周在Think 2018大會上各種公告背后的機器學習(ML)工作,這方面的工作很快將進一步加速Watson和PowerAI的訓練性能。這恰巧突出了IBM與NVIDIA的合作伙伴關系,以及NVIDIA針對GPU的NVlink互連技術。

去年,IBM曾有一篇論文提到了如何在不到一小時的時間內、高達95%的擴展效率以及75%的準確率訓練機器學習圖像分類模型,采用了和Facebook用于訓練一樣的數據集。2017年上半年,IBM使用面向高性能計算系統的基于POWER8的64位Power System S822LC運行了這一訓練基準測試。這些系統中的每一個都有采用4個NVIDIA Tesla P100 SXM2連接的GPU,并使用IBM的PowerAI軟件平臺和Distributed Deep Learning (DDL)。

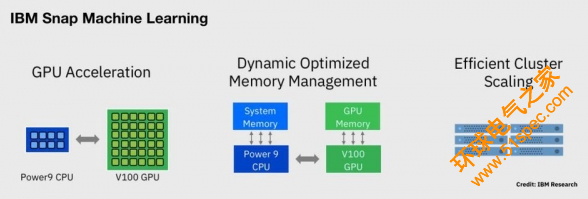

IBM的新論文“Snap Machine Learning”描述了一種新的IBM機器學習庫,可以更有效地利用可用的網絡、內存和異構計算資源,進行機器學習訓練任務,也是基于基于一個新的平臺——IBM Power Systems AC922服務器。IBM AC922通過NVIDIA最新的NVlink 2.0接口,將4個SXM2連接的NVIDIA Tesla V100 GPU連接到雙POWER9處理器。

IBM研究員兼IBM研究院加速認知基礎架構總監Hillery Hunter談到了IBM為Snap Snap ML提高性能所做出的貢獻:

- 更有效地將機器學習訓練算法映射到大規模并行的GPU微架構

- 更有效地從單一服務器機箱擴展到一個服務器集群

- 通過最小化異構處理節點(經典處理器和GPU)與動態內存調度器之間的通信,來改進內存管理,該調度器可將數據從處理器推測性地移動到GPU內存(反之亦然)

- IBM集成了NVIDIA NVlink互連技術,讓IBM POWER9能夠更快地與NVIDIA Tesla V100進行通信,目前這已經在IBM Power Systems AC922中支持了。

最終結果是,原來需要花費數小時的訓練任務,現在在幾秒鐘內就可以完成,而且不會降低準確性。這是有可能實現的,因為Snap可以更有效地分配和加速這些任務。Snap將加速多種邏輯和線性回歸分析,包括深度學習任務。

IBM聲稱使用Criteo Labs在線廣告訓練數據集的機器學習訓練記錄比之前發布的記錄提高了46倍,訓練準確性沒有任何損失。之前的結果是在一年前發布的,但更重要的是,Google使用純處理器的云虛擬機(VM)實例就實現了該結果。Google可以輕松組裝60個工作虛擬機實例和29個參數虛擬機實例(總共89個云處理器實例)進行訓練。

然而,即使在一年前,Google的結果也是一個暴力擴展處理器資源的示范,還有一個問題“為什么只用處理器周期進行訓練?”。在Google公布使用Criteo Labs訓練數據集結果的時候,還沒有發出最初的TensorFlow處理單元(TPU)。也許這就是Google為什么不使用TPU來生成(當時)紀錄結果的原因。

一年后,IBM僅使用4臺Power System AC922服務器,每臺服務器包含2個POWER9處理器和4個NVIDIA Tesla V100 GPU,就擊敗了Google的紀錄。這個結果是將89個云虛擬機實例與安裝在4個服務器機箱(8個處理器和16個GPU)中的總計24個計算元件進行比較,速度提高了46倍。

在關于Snap的論文中,IBM還將C9000服務器與基于英特爾處理器的主流服務器(使用Criteo Terabyte Click Log子集——前2億個訓練樣例,一個合理大小的子集)進行了直接比較。測試的系統是:

- 雙路Power System AC922服務器,采用的POWER9處理器通過NVlink 2.0連接至4個NVIDIA Tesla V100 GPU,但僅使用其中一個GPU進行比較

- 采用英特爾至強Gold 6150處理器的雙路槽服務器,通過PCIe 3.0連至1個NVIDIA Tesla V100 GPU

IBM測量了通過NVlink 2.0連接的AC922系統有效帶寬為68.1GB/s,通過PCIe 3.0連接、基于英特爾處理器的系統有效帶寬為11.8GB / s。對于使用NVlink 2.0的AC922系統來說,這是一個5.8x處理器與GPU互連相比的優勢。

Snap ML可管理處理器和GPU之間的數據移動。由于使用NVlink的數據傳輸速度幾乎快了6倍,所以Snap可以將處理器和GPU之間的數據拷貝時間隱藏在處理器和GPU的數據處理時間之后。

結果是,使用Power Systems AC922服務器的實際測量訓練時間加速了3.5倍多,每個系統只使用1個GPU。

數據移動嚴重影響了機器學習的性能;測量跨NVlink的單個GPU的性能,與跨PCIe的單個GPU的性能之間的關系,應該擴展到對比使用這些連接的多個GPU。但是,此測試很好地表明,使用由NVlink連接的IBM POWER9處理器,相對4個或更多NVIDIA Tesla GPU集群仍應具有可衡量的優勢。該測試還強調了對標準機器學習基準測試的需求,該基準測試能夠在使用真實應用的服務器之間進行直接比較。

訓練時間提速3.5倍,這與整體基準測試的性能領先同樣重要。

目前還沒有其他處理器制造商將NVIDIA NVlink互連技術直接集成到處理器套件中,所有競爭的服務器生態系統都依賴于PCIe互連。直接訪問NVlink和Snap ML軟件架構都有助于加速訓練。

在上周的Think 2018大會,IBM和蘋果公司宣布推出了IBM Watson Services for Core ML。這讓蘋果與IBM近4年的合作伙伴關系邁向了一個新的階段,讓蘋果iOS軟件開發人員能夠使用IBM領先的人工智能和機器學習開發環境,以及云訓練支持。雙方將IBM Watson擴展到在蘋果非常成功的消費設備生態系統上運行機器學習推理任務。更快速地培訓機器學習模型,意味著可以為邊緣設備(如基于iOS的智能手機)的推測任務提供更新的模型。

Snap ML將在今年晚些時候作為IBM PowerAI技術預覽組合的一部分問上市。

機器學習的訓練時間提高3.5倍,這與整體基準測試的性能領先同樣重要。

下一篇: PLC、DCS、FCS三大控

上一篇: 索爾維全系列Solef?PV